Поисковые технологии

-

2023-04-23 13:21:34

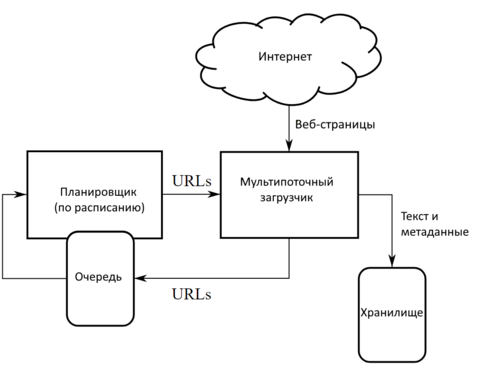

Краулер (от английского crawler — «ползать») — это поисковый робот, используемы поисковой системой для обнаружения новых страниц в интернете. Простыми словами, краулер — это поисковый робот Google, «Яндекса» и других поисковых систем.

Принцип работы заключается в постоянном сканировании страниц и нахождении на них ссылок с дальнейшим переходом по ним. Всю собранную информацию робот заносит в специальную базу данных, которая называется индексом. Данные о новых страницах в интернете поисковая машина берет как раз из такого индекса.

-

2021-04-28 04:16:35

В прошлой статье я рассказал о том, каким образом поисковая система может узнать о том, что существует та или иная веб-страница, и сохранить ее себе в хранилище. Но узнать о том, что веб-страница существует, — это только самое начало. Гораздо более важно за доли секунды успеть найти те страницы, которые содержат ключевые слова, введенные пользователем. О том, как это работает, я и расскажу в сегодняшней статье, проиллюстрировав свой рассказ «учебной» реализацией, которая тем не менее спроектирована таким образом, чтобы иметь возможность масштабироваться до размеров индексирования всего Интернета и учитывать современное состояние технологий анализа больших объемов данных.