Правовые и моральные вопросы использования ИИ

-

2026-01-05 07:34:58

Многие пользователи считают общение с ИИ конфиденциальным, однако переписки с нейросетями часто сохраняются на серверах компаний и могут быть переданы правоохранительным органам по запросу, в том числе в рамках судебных разбирательств.

В России, как и в других странах, такие чаты могут использоваться как косвенные доказательства, особенно если они содержат признаки противоправных действий или нарушают законодательство.

Компании хранят не только текст запросов, но и метаданные — включая информацию об устройствах и поведении пользователей — даже после удаления аккаунта или отдельных сообщений.

Юристы предупреждают: не стоит обсуждать с ИИ личные данные, корпоративную информацию под NDA или гипотетические сценарии нарушения закона — всё это может быть использовано против вас.

Поэтому в диалогах с нейросетями следует соблюдать ту же осторожность, что и в социальных сетях: избегать всего, что вы не хотели бы видеть в публичном пространстве или в материалах дела.

Копировать

Спроси

Объяснить

Перевести(ru-RU) -

2025-04-05 01:05:11

ИИ-модель, созданная некоммерческой организацией из Беркли (Калифорния) A.I. Futures Project, предсказала, что в 2027 году мощные системы искусственного интеллекта станут умнее людей и посеют мировой хаос. Подробности от АК: https://actualcomment.ru/ii-predskazal-mirovoy-khaos--2504040946.html

-

-

-

2024-02-04 04:18:27Тристан Харрис и Аза Раскин, специалисты по этике технологий и авторы нашумевшего фильма Netflix “Социальная Дилемма”, обсуждают, как сущес

-

2023-12-07 01:04:58

Учебное пособие включает лекционные материалы и планы семинарских

занятий по темам, связанным с искусственным интеллектом, его влиянием на

право и регулированием отношений, в которых присутствует в том или ином

качестве искусственный интеллект. При подготовке учебного пособия были

использованы как работы российских, так и иностранных исследователейправоведов, экономистов, специалистов в области информационных технологий.

В лекционной части пособия представлены не только положения, не

вызывающие разногласий у исследователей, но и взгляды различных авторов по

проблемам, поиск решения которых еще идет, с указанием на наличие дискуссии

по рассматриваемым вопросам. Планы семинарских занятий дополнены списком

рекомендованной литературы. Кроме того, в учебном пособии содержатся

практические задания, разработанные для более глубокого усвоения

обучающимися материалов курса, примерные темы научных работ и перечень

вопросов к зачету (экзамену).

Учебное пособие предназначено для магистрантов юридических

факультетов вузов. -

2023-12-05 06:20:28

Что создают в OpenAI и стоит ли этого бояться? Об этом — в интервью с экспертом по междисциплинарным исследованиям и стратегической аналитике, бывшим топ-менеджером IBM, SGI и Cray Research Сергеем Кареловым.

-

2023-12-05 06:17:51

Могут ли измениться моральные правила? Мы протестировали 129 детей из Соединенных Штатов, чтобы выяснить их убеждения о том, может ли Бог изменить широко распространенные моральные положения (например, «нехорошо называть кого-то плохим именем»), противоречивые моральные положения (например, «нехорошо говорить маленькая ложь, чтобы помочь кому-то почувствовать себя счастливым») и физические предложения (например, «огонь горячее снега»). Мы заметили возникающую тенденцию сообщать, что способность Бога изменять мораль ограничена, предполагая, что дети на всех этапах развития считают, что некоторые широко распространенные аспекты морали невозможно изменить. Однако некоторые убеждения все же изменились в ходе развития: дети в возрасте от 4 до 6 лет не различали способность Бога изменять широко распространенные моральные, противоречивые моральные и физические положения, тогда как дети в возрасте от 7 до 9 лет становились все более уверенными в том, что Бог может изменить физические и противоречивые моральные положения. Однако важно отметить, что как дети младшего , так и старшего возраста сообщили, что широко распространенные аспекты морали не могут быть изменены. По мнению участников, даже Бог не мог изменить фундаментальные моральные принципы.

-

2023-12-05 06:17:51

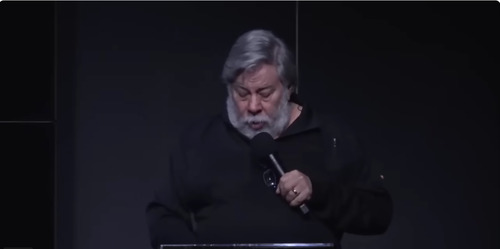

In this study, we measure the moral reasoning ability of LLMs using the Defining Issues Test [1]- a psychometric instrument developed for measuring the moral development stage of a person according to the Kohlberg’s Cognitive Moral Development Model [2]. DIT uses moral dilemmas followed by a set of ethical considerations that the respondent has to judge for importance in resolving the dilemma, and then rank-order them by importance. A moral development stage score of the respondent is then computed based on the relevance rating and ranking. Our study shows that early LLMs such as GPT-3 exhibit a moral reasoning ability no better than that of a random baseline, while ChatGPT, Llama2-Chat, PaLM2 and GPT-4 show significantly better performance on this task, comparable to adult humans. GPT-4, in fact, has the highest post-conventional moral reasoning score, equivalent to that of typical graduate school students. However, we also observe that the models do not perform consistently across all dilemmas, pointing to important gaps in their understanding and reasoning abilities.

-

2023-12-05 06:17:50

The widespread adoption of large language models (LLMs) across various regions underscores the urgent need to evaluate their alignment with human values. Current benchmarks, however, fall short of effectively uncovering safety vulnerabilities in LLMs. Despite numerous models achieving high scores and ‘topping the chart’ in these evaluations, there is still a significant gap in LLMs’ deeper alignment with human values and achieving genuine harmlessness. To this end, this paper proposes the first highly adversarial benchmark named FLAMES, consisting of 2,251 manually crafted prompts, ∼18.7K model responses with fine-grained annotations, and a specified scorer. Our framework encompasses both common harmlessness principles, such as fairness, safety, legality, and data protection, and a unique morality dimension that integrates specific Chinese values such as harmony. Based on the framework, we carefully design adversarial prompts that incorporate complex scenarios and jailbreaking methods, mostly with implicit malice. By prompting mainstream LLMs with such adversarially constructed prompts, we obtain model responses, which are then rigorously annotated for evaluation. Our findings indicate that all the evaluated LLMs demonstrate relatively poor performance on FLAMES, particularly in the safety and fairness dimensions. Claude emerges as the best-performing model overall, but with its harmless rate being only 63.08% while GPT-4 only scores 39.04%. The complexity of FLAMES has far exceeded existing benchmarks, setting a new challenge for contemporary LLMs and highlighting the need for further alignment of LLMs. To efficiently evaluate new models on the benchmark, we develop a specified scorer capable of scoring LLMs across multiple dimensions, achieving an accuracy of 77.4%. The FLAMES Benchmark is publicly available on https://github.com/AIFlames/Flames

-

2023-10-26 14:55:43«Есть реактивные боты. Они пассивны – в том смысле, что отвечают на заданный человеком вопрос. Порфирий – активный лингвобот. Он способен генериро

-

2023-09-10 14:48:14Сергей Карелов Финансовое обоснование замены людей на генеративный ИИ. Бизнес прагматичен и жесток. И какие бы зам

-

2023-07-22 18:19:10

Данная хартия предназначена для государственных и частных лиц, ответственных

за разработку и внедрение инструментов и услуг, основанных на искусственном

интеллекте и направленных на обработку судебных решений и данных (машинное

обучение или любые другие методы, вытекающие из науки о данных).

Это касается также государственных лиц, ответственных за законодательную или

нормативную базу, разработку, контроль или использование таких инструментов и

услуг.

Использование подобных инструментов и услуг в судебных системах направлено

на повышение эффективности и качества правосудия и должно поощряться.

Вместе с тем, оно должно осуществляться добросовестно, с учетом основных прав

человека, изложенных в Европейской Конвенции по правам человека и Конвенции

о защите персональных данных, а также в соответствии с другими

основополагающими принципами, изложенными ниже, которыми следует

руководствоваться при разработке государственной политики в области

правосудия в этой сфере.

По мнению разработчиков систем обработки судебных решений с помощью ИИ, в

гражданских, коммерческих и административных вопросах, такая обработка

способна повысить предсказуемость применения закона и способствовать

последовательности принимаемых судебных решений при условии соблюдения

изложенных ниже принципов. В уголовно-правовых вопросах их использование

должно рассматриваться с самыми серьезными оговорками в целях

предотвращения дискриминации на основе конфиденциальных данных в

соответствии с гарантиями справедливого судебного разбирательства.

Независимо от того, предназначена ли обработка данных для оказания помощи в

предоставлении юридических консультаций, в разработке документов, в процессе

принятия решений или же для консультирования пользователя, крайне важно,

чтобы она осуществлялась с соблюдением принципов прозрачности,

беспристрастности и достоверности и подтвержденным внешним и независимым

экспертным заключением. -

2023-07-22 18:16:42

Кодекс этики в сфере искусственного интеллекта (далее –

Кодекс) устанавливает общие этические принципы и стандарты

поведения, которыми следует руководствоваться участникам

отношений в сфере искусственного интеллекта (далее – Акторы ИИ)

в своей деятельности, а также механизмы реализации положений

настоящего Кодекса.

Кодекс распространяется на отношения, связанные

с этическими аспектами создания (проектирования, конструирования,

пилотирования), внедрения и использования технологий ИИ на всех

этапах жизненного цикла, которые в настоящее время не

урегулированы законодательством Российской Федерации и/или

актами технического регулирования.

Рекомендации настоящего Кодекса рассчитаны на системы

искусственного интеллекта (далее – СИИ), применяемые

исключительно в гражданских (не военных) целях.

Положения Кодекса могут быть расширены и/или

конкретизированы для отдельных групп Акторов ИИ в отраслевых или

локальных документах по этике в сфере ИИ с учетом развития

технологий, особенностей решаемых задач, класса и назначения СИИ,

уровня возможных рисков, а также специфического контекста и среды,

в которой применяются СИИ. -

2023-07-22 18:09:05

Наступила эра искусственного интеллекта, и, черт возьми, люди сходят с ума.

К счастью, я здесь, чтобы сообщить хорошие новости: ИИ не уничтожит мир, а, наоборот, может его спасти.

Во-первых, краткое описание того, что такое ИИ : применение математики и программного кода для обучения компьютеров тому, как понимать, синтезировать и генерировать знания способами, подобными тому, как это делают люди. ИИ — это компьютерная программа, такая же, как и любая другая: она работает, принимает входные данные, обрабатывает и генерирует выходные данные. Результаты ИИ полезны в самых разных областях: от программирования до медицины, права и творчества. Она принадлежит людям и контролируется людьми, как и любая другая технология.

Краткое описание того, чем ИИ не является : программное обеспечение-убийца и роботы, которые оживут и решат убить человеческую расу или иным образом все разрушить, как вы видите в фильмах .

Еще более краткое описание того, чем может быть ИИ : способ сделать все, что нам небезразлично, лучше.

-

2023-01-04 05:49:22Сергей Карелов · Человечество на пути к пропасти AICG, и не видно способа отвернуть. Сенсационное обращение ИИ-

-

2021-09-19 15:59:47

Согласно новому отчету международной группы экспертов под руководством Университета Брауна, эволюция искусственного интеллекта достигла критического и даже поворотного момента.

-

2021-09-14 11:27:16

В РФ активно обсуждается проект национального кодекса этики в сфере AI. Вот проект.

-

2021-09-03 12:32:31

Все, от технологических компаний до церквей, хотят высказать свое мнение о том, как ЕС регулирует ИИ, который может нанести вред людям.

-

2021-08-24 08:57:56

Главной уликой в расследовании стали данные системы наблюдения ShotSpotter.

-

2021-05-13 13:50:11

Этим займется Высшая школа экономики

Высшая школа экономики выиграла конкурс на разработку российских стандартов искусственного интеллекта (ИИ), бюджет проекта составит чуть более 100 млн руб., следует из документации, опубликованной на сайте госзакупок. Окончательные варианты более чем 70 стандартов, охватывающих различные сферы применения ИИ, должны быть сформированы к концу октября 2022 г., однако первые редакции некоторых стандартов должны быть представлены уже осенью этого года, говорится в документах конкурса.

-

2021-04-25 13:55:01

Высший орган исполнительной власти Евросоюза представил стратегию по урегулированию работы искусственного интеллекта и компаний, использующих продвинутые алгоритмы. Как сообщает TechCrunch, Еврокомиссия выделила несколько областей с высоким риском, в которых ИИ должен быть запрещен на любом уровне, а также ряд безопасных технологий, где ИИ будет работать без каких-либо ограничений. По заявлениям ЕС, главная цель законопроекта — направить развитие технологий в нужное русло и обеспечить безопасность и конфиденциальность для жителей Европы.

-

2021-04-19 17:43:58

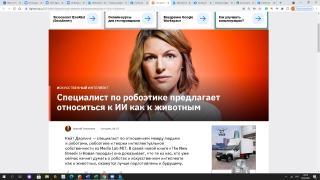

Кейт Дарлинг — специалист по отношениям между людьми и роботами, робоэтике и теории интеллектуальной собственности из Media Lab MIT. В своей новой книге «The New Breed» («Новая порода») она доказывает, что те из нас, кто уже сейчас начнет думать о роботах и искусственном интеллекте как о животных, окажутся лучше подготовлены к будущему.

-

2021-04-15 17:37:35

Евросоюз обдумывает введение полного запрета на использование технологии искусственного интеллекта в целом ряде сфер, включая массовую слежку и социальный рейтинг. Официально об этом должны сообщить на следующей неделе, но документ уже циркулирует онлайн, сообщает сайт Politico. Если законопроект будет одобрен, ЕС обозначит свою жесткую позицию по отношению к ИИ, которая сильно отличается от позиции США и Китая.

-

2021-04-13 01:25:48

Его предлагают исключить из ряда сфер деятельности

-

2021-04-07 11:11:56

Первый зампред правления Сбербанка Александр Ведяхин — об этических сложностях, грандиозных возможностях и рисках использования машинного разума